Japonya’da bir bilim insanı, beyin taramaları ve yapay zekâ kullanarak kişinin zihnindeki görüntüleri doğru ve açıklayıcı cümlelere dönüştürebilen bir teknik geliştirdi.

Tokyo yakınlarındaki NTT İletişim Bilimleri Laboratuvarları’nda araştırmacı olarak görev yapan Tomoyasu Horikawa, çalışmasını 5 Kasım’da Science Advances dergisinde yayımladı.

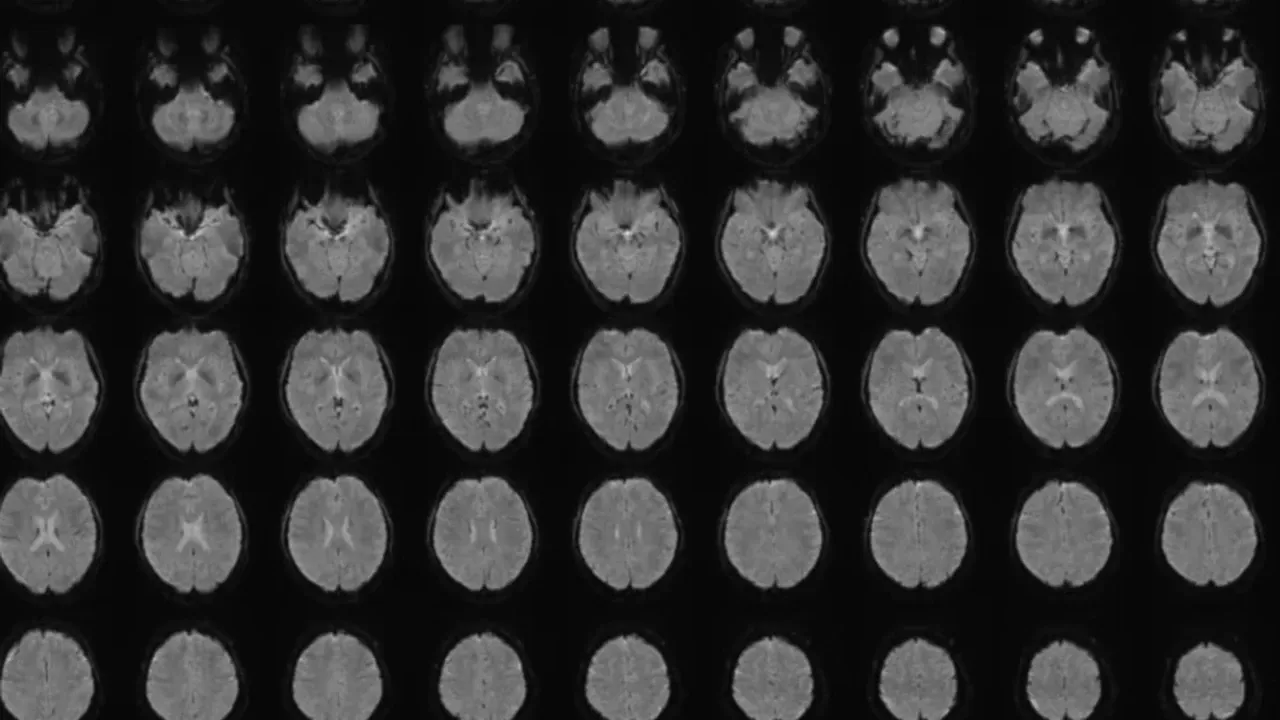

Beyin görüntülerini metne dönüştüren yapay zekâ geliştirildi

Horikawa’nın geliştirdiği yöntem “zihin altyazısı” (mind-captioning) olarak adlandırılıyor. Bu yöntem, beyindeki görsel bilgileri — nesneler, mekânlar, eylemler ve bunlar arasındaki ilişkiler — tanımlayan metinler üretmek için yapay zekâdan yararlanıyor.

Araştırmada 22-37 yaşları arasındaki 6 Japon katılımcının beyin aktiviteleri, 2180 sessiz video klip izlerken tarandı. Büyük dil modelleri (LLM), videolara ait altyazıları sayısal dizilere dönüştürdü ve ardından “çözücüler” (decoders) olarak adlandırılan yapay zekâ modelleri, beyin aktiviteleri ile bu dizileri eşleyecek şekilde eğitildi.

“Zihin altyazısı” ile zihinsel imgeler yazıya aktarılıyor

Sonrasında çözücüler, katılımcılar daha önce görmediği videoları izlerken veya hatırlarken oluşan beyin aktivitelerini yorumladı. Başka bir algoritma ise bu beyin sinyallerine uygun kelime dizilerini adım adım oluşturdu. Yapay zekâ, veriyle beslendikçe, katılımcıların izledikleri videoları betimleme konusunda giderek daha başarılı hale geldi.

Model, katılımcılar İngilizce konuşmasa da metinleri İngilizce olarak üretebildi. Horikawa, yöntemin beynin dil merkezine ihtiyaç duymadan çalıştığını, dolayısıyla dil bölgesinde hasar olan bireylerde de kullanılabileceğini vurguladı.

Bu teknoloji, afazi veya ALS gibi konuşmayı etkileyen hastalıkları olan kişiler için iletişimi kolaylaştırmak amacıyla kullanılabilir.